性能瓶颈:Python在处理大量数据时的优化技巧

Python在处理大量数据时,确实存在一些性能瓶颈。以下是一些优化技巧:

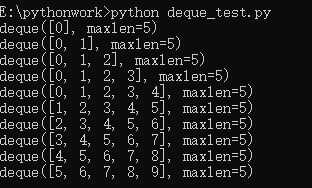

使用适当的数据结构:

- 列表(List)适合随机插入和删除。

- 链表(Linked List)适用于顺序访问和插入。

- 栈(Stack)和队列(Queue)是高效的数据管理工具。

批量处理数据:

- 尽可能一次性读取所有数据,避免频繁磁盘I/O。

使用适当的数据库:

- 对于结构化的数据,如关系型数据库(MySQL, PostgreSQL等),应考虑其性能特点进行操作。

- 对于非结构化数据,可以使用NoSQL数据库(MongoDB, Redis等)。

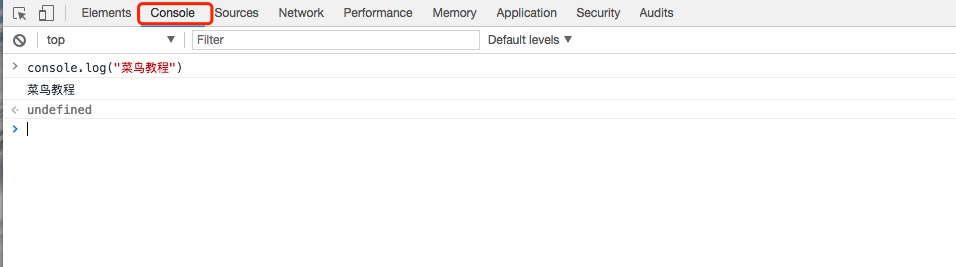

利用Python库和工具:

pandas是处理大量数据的强大工具,适合进行数据分析和清洗。numpy提供了高性能的数组计算功能。

合理分配任务:

- 使用多线程或多进程来并发处理数据,提高性能。

- 对于CPU密集型任务,使用Python的

multiprocessing库;对于I/O密集型任务,尽量避免磁盘操作。

通过以上优化技巧,可以有效提升Python处理大量数据时的性能。

还没有评论,来说两句吧...